Sistrix: Sichtbarkeitsindex interpretieren & Einbrüche verstehen

Wir stellen immer wieder fest, dass viele Leute ihre Sistrix-Daten falsch interpretieren und sich zu sehr auf Schwankungen der Sichtbarkeit fixieren. Heute gebe ich Dir daher Tipps zum Sistrix-Sichtbarkeitsindex, erkläre typische Missverständnisse und zeige Dir, was Du bei einem Sichtbarkeitsverlust tun kannst.

Was ist der Sistrix Sichtbarkeitsindex und wie interpretiere ich ihn?

Rund eine Million Keywords bilden als Grundlage das Suchverhalten im jeweiligen Land ab. Die Sichtbarkeit erhebt Sistrix täglich bzw. montäglich, für Desktop und Mobile in insgesamt 30 Ländern. Das ist also eine recht beachtliche Datenbasis. Mehr zum SI findest Du hier: https://www.sistrix.de/support/sistrix-sichtbarkeitsindex

Der Sistrix-Sichtbarkeitsindex zeigt die Auffindbarkeit in der organische Google-Suche. Sie berechnet sich über das Suchvolumen und die Rankingposition der Keywords im Sistrix Pool im ausgewählten Land, auf dem ausgewählten Gerät (Desktop oder Mobile) im Zeitverlauf.

Grundsätzlich gilt:

- Je höher das Ranking für ein bestimmtes Keyword

- Je mehr Rankings für Keywords

- Und je trafficstärker diese Keywords

Desto höher der Sichtbarkeitsindex.

Um die Sichtbarkeit einzuordnen, ob sie also gut, schlecht, hoch oder niedrig ist, musst Du die Sichtbarkeit in Bezug setzen, zum Beispiel zu anderen Domains.

Insbesondere musst Du herausfinden, ob eine Sichtbarkeitsveränderung einen Effekt auf Deine Kern-KPIs (Traffic, Umsatz…) hat und damit für Dich relevant ist, oder nicht! Denn wenn Du für ein für Dich unwichtiges, aber trafficstarkes Keyword weit oben positioniert bist, kann das zu einer erhöhten Sichtbarkeit führen – die Dir aber nicht viel bringt.

Seokratie hat beispielsweise gute Rankings für das Keyword „Länge“, das viel Traffic hat. Aber wirklich relevant ist dieser Suchbegriff nicht – trotzdem zählt er in die Sichtbarkeit mit ein. Andere SEO Tools wie Searchmetrics, Xovi oder Metrics Tools haben ebenfalls Sichtbarkeitsindizes. Jedes Tool nutzt aber eine andere Daten- und Berechnungsgrundlage, so dass Du bei Nutzung verschiedener Tools auch verschiedene Ergebnisse erhalten wirst.

Sichtbarkeit auf der richtigen Ebene erfassen

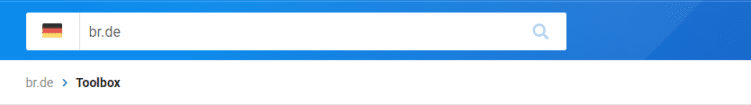

Um die Sichtbarkeit einer Domain zu erhalten, schreibe sie in den Suchschlitz und passe gegebenenfalls das Land durch Klicken auf die Länderflagge an. Ich habe hier die Domain des Bayerischen Rundfunks gewählt, und möchte Daten für Deutschland sehen.

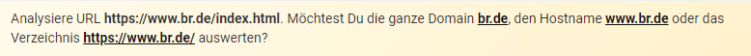

Falls Du nicht eine Domain angegeben hast, sondern eine Seite wie etwa die BR-Startseite https://www.br.de/index.html, dann fragt Sistrix nach, was Du genau analysieren möchtest.

Du könntest beispielsweise auch ein Verzeichnis oder einen Host betrachten. Für den größten Überblick zu Deiner Website, inklusive aller Subdomains, Verzeichnisse und Varianten, wähle „Domain“.

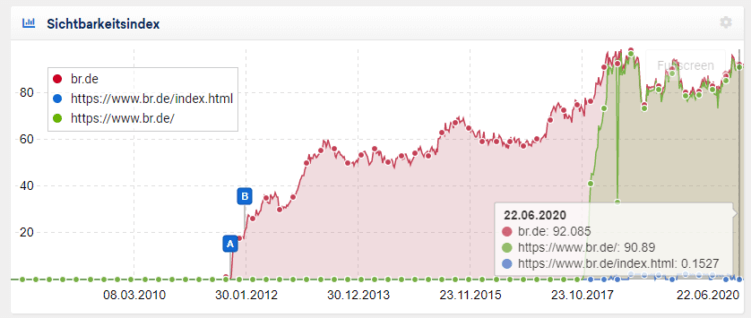

Im folgenden Bild siehst Du die Unterschiede in der Sichtbarkeit:

In Deinen Profil-Einstellungen kannst Du übrigens festlegen, was Dein Standard-Land ist und ob Du primär die mobile Sichtbarkeit sehen willst. Dies macht Sinn, wenn ein Großteil Deiner Nutzer mit Smartphones auf Deiner Seite surft und um der Mobile-First-Indexierung Rechnung zu tragen. Als Grundeinstellung ist hingegen zunächst die Desktop-Sichtbarkeit für PC-User hinterlegt.

Sichtbarkeitsänderung mit Ereignissen korrelieren

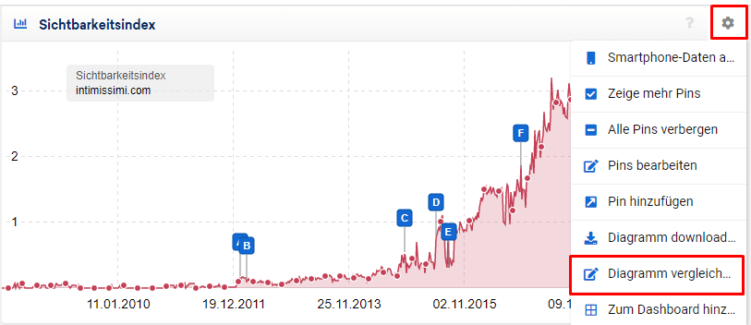

Schwankungen in der Sichtbarkeit können im Zusammenhang mit bestimmten Ereignissen stehen. Die blauen Pins im Screenshot sind Google Updates, die Sistrix selbst einzeichnet. Du kannst auch oben rechts auf das Zahnrad klicken und eigene Pins für Ereignisse hinzufügen, um beispielsweise zu erfassen, wie sich die Sichtbarkeit vor- und nach einem Relaunch verhält.

Das hilft dir später bei der Analyse einer Sichtbarkeitsveränderung: Wenn Deine Sichtbarkeit sich rund um einen Pin, also ein Ereignis, stark ändert, dann hatte dieses Ereignis vermutlich einen Einfluss darauf.

Sichtbarkeit im Vergleich zur Konkurrenz betrachten

Um die Sichtbarkeit einzuordnen, hilft ein Konkurrenzvergleich. Auch hier gehst Du über das Zahnrad:

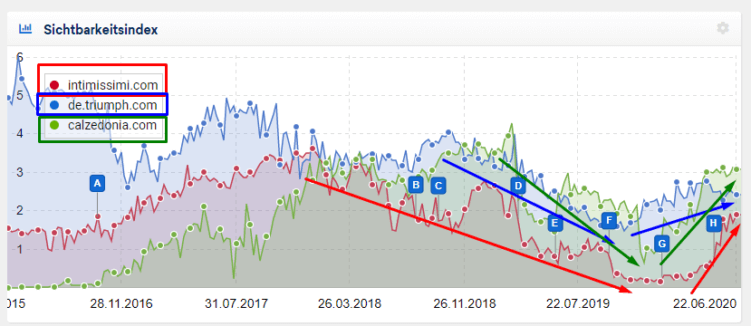

Wenn ich etwa einen Wäscheshop betreibe, könnte ich die Sichtbarkeit großer Player in meinem Bereich vergleichen.

Die Entwicklungen von calzedonia (grün) und intimissimi (rot) finde ich besonders interessant, denn in letzter Zeit stiegen beide stärker an, als triumph (blau). Diese beiden Wettbewerber könnte ich als mögliche Vorbilder genauer betrachten.

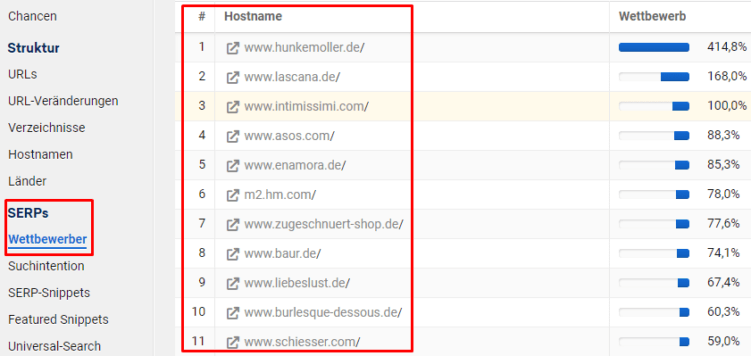

Tipp: Wer Deine Keyword-Wettbewerber sind, verrät dir Sistrix unter dem Punkt SERPs > Wettbewerber.

Sichtbarkeit international prüfen

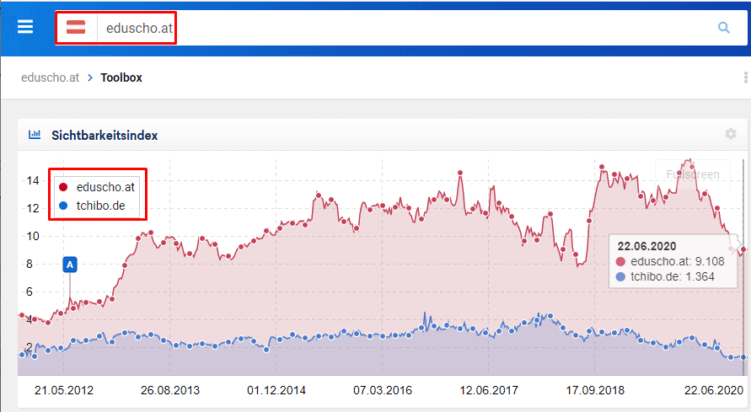

Bei internationalen Domains solltest Du prüfen, ob die richtige Version rankt. Beispielsweise sollte in Österreich – falls vorhanden – die AT-Variante sich nicht mit der ebenfalls deutschsprachigen DE-Variante in die Quere kommen. Hier kann Sistrix ein Indikator dafür sein, ob die Ausrichtung z.B. über das hreflang-Attribut korrekt ist.

Bei Tchibo rankt beispielsweise in Österreich neben eduscho.at auch die tchibo.de-Variante:

Einschränkungen der Sichtbarkeit

Im Folgenden habe ich wichtige Einschränkungen zur Aussagekraft der Sichtbarkeit gesammelt, die Dir bei der richtigen Interpretation Deiner Daten helfen.

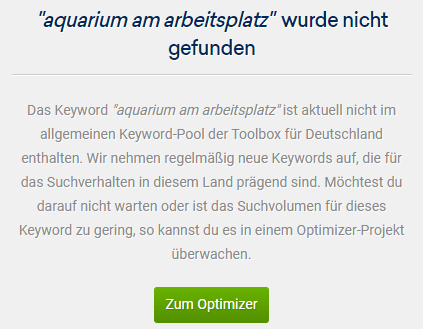

Nischen- und Longtailkeywords werden nicht voll erfasst

Je mehr Deine Website in einer Nische verortet ist, desto weniger Deiner Keywords sind in Sistrix und desto größer ist der Einfluss von für Dich wenig relevanten Keywords auf Deine Sichtbarkeit. Dies liegt daran, dass der zugrunde liegende Keyword-Pool, für den Sistrix Daten sammelt, zwangsläufig begrenzt ist. Er orientiert sich an einem Querschnitt häufiger Suchanfragen.

- Bist Du in einer Nische unterwegs oder verkaufst Spezialteile?

- Sind die Begriffe, die Dein Angebot beschreiben, nicht unbedingt im Standard-Wortschatz enthalten?

Dann erfasst Sistrix Dein Marktsegment vermutlich nicht umfänglich, insbesondere nicht alle Keyword-Variationen (Prismenbrille vs Brille Prismengläser) und nicht alle relevanten Longtail-Begriffe. Wenn ein Keyword nicht im Sistrix Pool enthalten ist, sieht das so aus:

Sichtbarkeit bei kleinen Werten

Bei kleinen Sichtbarkeiten, definitiv aber bei Sichtbarkeiten kleiner als 1, ist die Aussagekraft sehr eingeschränkt, denn hier haben schon kleine Veränderungen im Ranking weniger Keywords einen sehr großen Einfluss. Wenn Ebay.de von einer Sichtbarkeit 639 auf 826 steigt, dann hat das ganz bestimmt auch Auswirkungen auf den Traffic. Wenn Deine Domain von einer 0,8 auf eine 0,9 steigt, dann kann es Auswirkungen haben – oder auch nicht. Sieh am besten einmal in Google Analytics, ob sich hier etwas getan hat.

Einfluss Brands und große Suchvolumen

Brand Keywords (insbesondere bekannte Marken, die im SEO meist nicht den Fokus bilden), können einen gewaltigen Einfluss auf Deine Sichtbarkeit haben. Das gleiche gilt für Keywords mit großem Suchvolumen – dabei sind diese Keywords für Dich vielleicht gar nicht so relevant, oder ranken auf einer hinteren Position, wo kaum geklickt wird. Du siehst nicht direkt, welche Keywords für die Sichtbarkeitsschwankung verantwortlich sind. Um Klarheit über verschlechterte Keywordrankings zu erhalten, musst Du in den Tab Rankingveränderung wechseln. Das erkläre ich weiter unten.

Bei Änderungen der Sichtbarkeit ist die Relevanz der Keywords und Rankings entscheidend! Der Sichtbarkeitsindex ist insbesondere im Vergleich (zu Konkurrenten, zwischen Verzeichnissen) sowie im Verlauf interessant.

Wie gehe ich nach einem Sichtbarkeitsverlust vor?

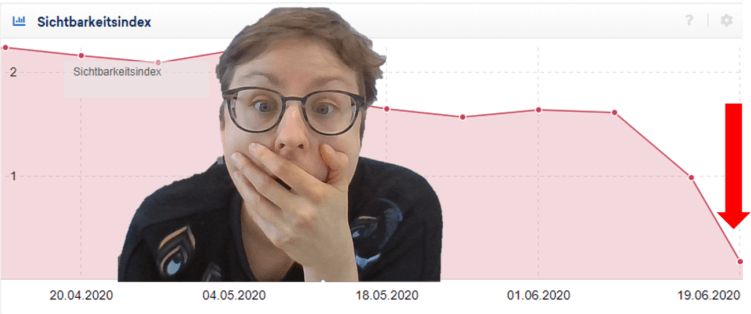

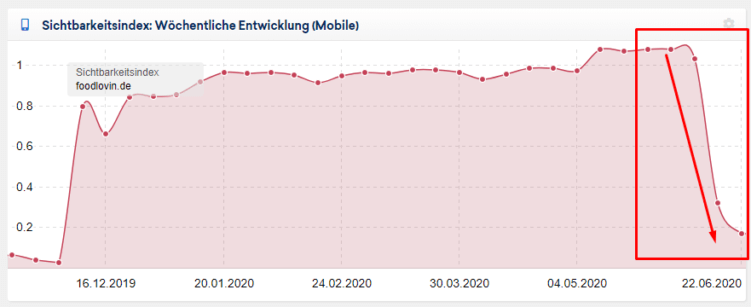

Was machst Du, wenn Du eine Entwicklung bei Deiner Seite siehst, wie hier – fast Minus 69 % in der mobilen Sichtbarkeit?

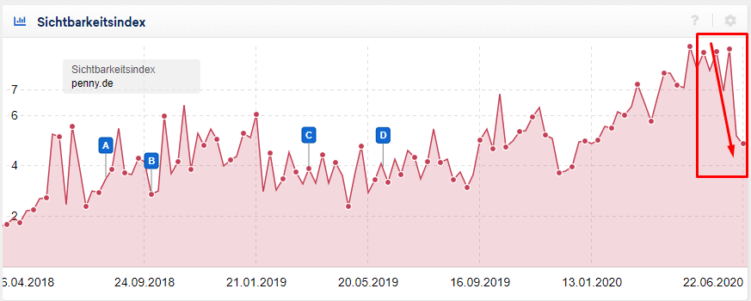

Oder einen deutlichen Einbruch in der Desktop-Sichtbarkeit?

Anmerkung: Die Beispiele habe ich beispielsweise der Sistrix Übersicht unter https://de.sistrix.com/seo entnommen, um das Vorgehen zur Ursachenforschung bei Ranking-Einbrüchen zu illustrieren. Ich habe keine weiteren Einblicke in die Websites, die Online-Strategien und auch keine Zugänge zu Daten aus der Google Search Console, so dass ich die tatsächlichen Auswirkungen nicht kenne.

1. Ruhig bleiben

Du solltest grundsätzlich nicht die Nerven verlieren. Nur weil etwas dramatisch aussieht, muss es noch lange nicht dramatisch sein. Ob ein Sichtbarkeitseinbruch sich also für eine Website auch dramatisch auswirkt, kann man nur auf Grund des Verlaufs nicht sagen. Deshalb kommen wir direkt zum nächsten Punkt.

2. Auswirkungen prüfen

Was Du sofort tun solltest: in der Search Console oder in Google Analytics überprüfen, ob auch der organische Traffic abgenommen hat und gegebenenfalls, ob andere für Dich relevante KPIs leiden, wie etwa Deine Umsätze.

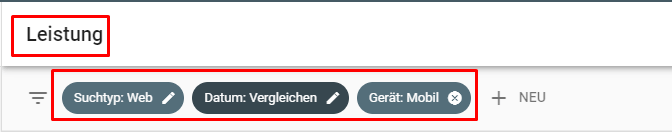

In der Google Search Console solltest Du für einen Überblick zu Auswirkungen auf den Traffic den Bericht Leistungen mit den organischen Klicks aufrufen und einige Filtereinstellungen treffen. Wenn z.B: der Mobile-Sichtbarkeitsindex eingebrochen ist, betrachte die mobilen Zugriffe.

Neben der Betrachtung des Klick-Verlaufs über einen längeren Zeitraum, führe auch einen Vergleich von zwei Zeitpunkten oder zwei Zeiträumen durch: zum Beispiel, der Montag, an welchem der Einbruch registriert wurde, mit dem vorangegangenen Montag, welcher eine höhere Sichtbarkeit hatte, oder die Woche im Vergleich zur Vorwoche.

Danach kannst Du die Suchbegriffe und die Landingpages nach verlorenen Klicks sortieren, um einen besseren Überblick der Auswirkungen zu erhalten:

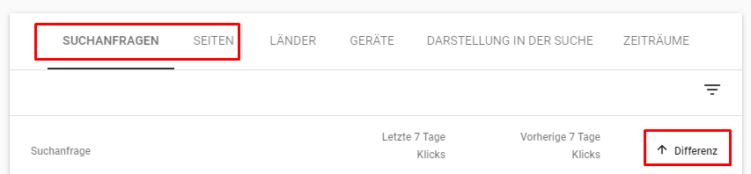

In Analytics kannst Du zudem unter eCommerce nachsehen, ob Transaktionen oder Umsätze durch Organic einbrechen:

Beachte: Wenn Du an dem Tag recherchierst, an dem der Sichtbarkeitsverlust verzeichnet wurde, stehen Dir nicht so viele und damit weniger aussagekräftige Daten zur Verfügung. Wichtig ist die richtige Einordnung der Daten. Bei kurzen Zeiträumen können viele Effekte die Klicks stark beeinflussen, sogar das Wetter. Ebenso spielen die durchschnittlichen Klicks eine Rolle: Wenn Du normalerweise 100 Klicks am Tag erhältst, sieht eine zufällige Schwankung von 10 Klicks schon sehr bedeutsam aus. Der 7-Tage-Vergleich und der Vergleich zweier Daten sind also statistisch nur bedingt aussagekräftig. Wenn Du aber merkst, dass der Sichtbarkeitsverlust mit einem Trafficeinbruch einhergeht, dann musst Du weiter nach der Ursache suchen und diese beheben.

3. Korrelationen erkennen

Wenn Du also Rankings und Traffic verloren hast, dann frage Dich, was in letzter Zeit auf Deiner Website passiert ist: Gab es etwa einen Relaunch, wurde ein neues Plugin installiert, das Webdesign angepasst, URLs gelöscht oder die interne Verlinkung verändert? Der Grund für Deinen Rankingverlust kann auch ein Google-Update, im Sichtbarkeitsindex eingezeichnet durch Pins, sein. Dabei wird beispielsweise die Nutzerfreundlichkeit einer Seite insbesondere auf Mobilgeräten immer wichtiger. Ebenso gewinnen die EAT-Faktoren (Expertise, Authority und Trust) an Einfluss. Hier kannst Du z.B. im Sistrix-Blog nach Veröffentlichungen suchen und in der SEO-Gemeinde nach Tipps recherchieren. Falls Deine Website in Zusammenhang mit einem Google Update Rankings einbüßt, kann es auch sein, dass die Sichtbarkeit sich bald wieder erhöht, denn manchmal korrigiert Google in einem zweiten Update übermäßige Auswirkungen.

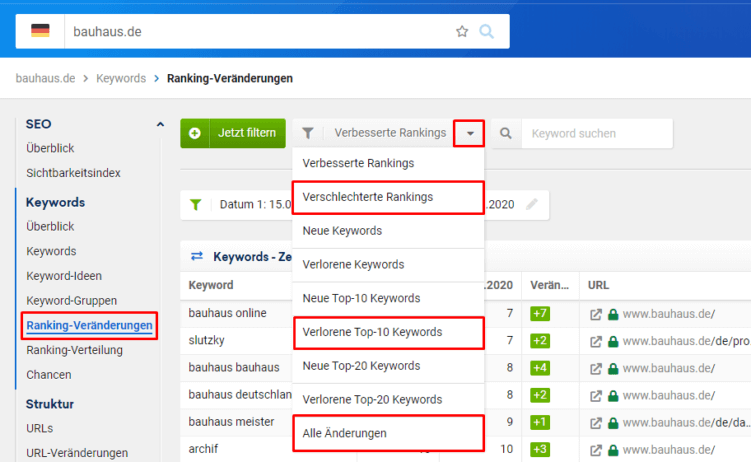

4. Keywords analysieren

Die Sichtbarkeit hängt an Keyword-Rankings. Wichtig für das Troubleshooting in Sistrix ist es deshalb, Antworten auf die folgenden Fragen zu finden:

- Einordnung: Welche Keywords haben den Sichtbarkeitsverlust verursacht? Thematisches Gruppieren hilft beim Überblick.

- Relevanz: Brauchst Du die Keywords überhaupt – brachten sie vor der Verschlechterung sinnvollen Traffic und Conversions? Sehr wichtig ist dazu die Prüfung in der Google Search Console und Google Analytics.

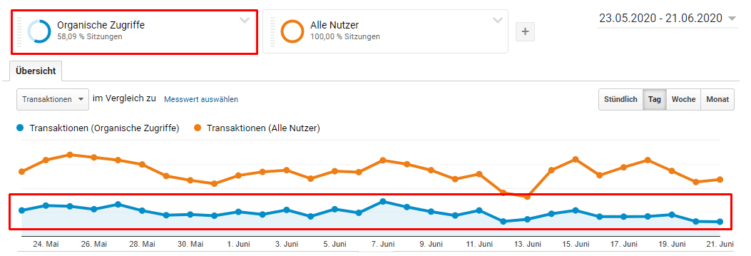

Die Sistrix-Berichte zu verschlechterten Keywords, Verlorenen Top-Ten-Keywords und Allen Änderungen sind eine Goldgrube wichtiger Daten für die Beantwortung der Fragen! Hier stecken die Infos, auf deren Basis Du Entscheidungen und Maßnahmen treffen kannst. Rufe dazu die Rankingveränderungen auf:

Wähle nun entweder die verlorenen Top 10 Keywords (für eine schnelle erste Einordnung, zeigt nur Keywords, die aus den wichtigen Top Ten gefallen sind), die verschlechterten Rankings (hier siehst Du keine komplett verlorenen Rankings), oder Alle Änderungen (umfassendste Datenbasis).

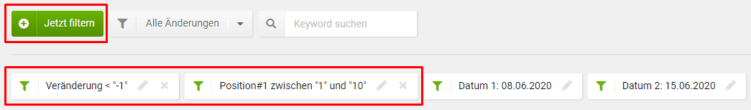

Nutze am besten den Bericht „Alle Änderungen“ und filtere nach „Veränderung <= -1“. Das erfasst alle Keyword-Rankings, die sich vom ersten zum zweiten Datum verschlechtert haben oder ganz verloren gingen.

Die Daten kannst Du direkt exportieren und weiter in Excel aufbereiten, oder Du bleibst in Sistrix. Du kannst die Auswahl auch noch weiter einschränken, etwa auf Keywords ab einem bestimmten Suchvolumen und auf Keywords, die zum ersten Zeitpunkt in den wichtigen Top-10 positioniert waren. So erhälst Du hilfreichere Einblicke und wirst nicht von der Datenflut erschlagen.

Sortiere die Ergebnisse dann absteigend nach Suchvolumen und Du erhältst einen kompakten Überblick verschlechterter Keywords vom ersten zum zweiten Datum.

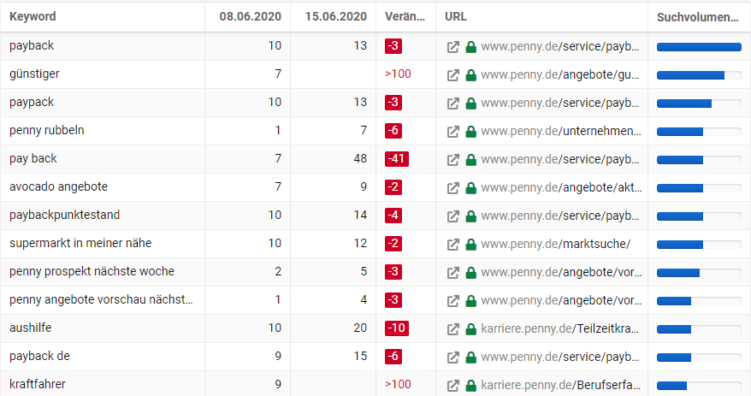

Manchmal erkennt man auf einen Blick, dass sich viele verschlechterte Rankings um ein Thema drehen und zu einer Landingpage oder einem Verzeichnis gehören, wie im folgenden Beispiel das Thema Payback bei Penny :

In so einem Fall kannst Du direkt weiter zur Landingpage- bzw. Verzeichnisbetrachtung schreiten. Falls die Zuordnung aber nicht so leicht erkennbar ist, gruppiere die Keywords und Landingpages in Excel für eine bessere Übersicht.

Du willst keine unserer Beiträge mehr verpassen und auf dem Laufenden bleiben? Abonniere jetzt unseren Newsletter und erhalte jeden neuen Seokratie-Beitrag per E-Mail direkt in Dein Postfach!

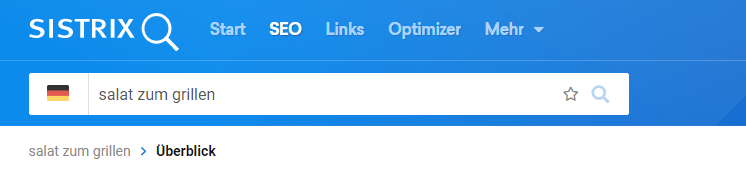

Jetzt abonnierenIn Sistrix kannst Du auch einzelne Keywords genauer betrachten. Wenn Du ein Keyword anklickst, wandert es in den Suchschlitz, und Du kannst es analysieren.

Wähle beispielsweise den SERP-Vergleich (Search Engine Result Page) um die Rankingveränderungen in den SERPs zu sehen:

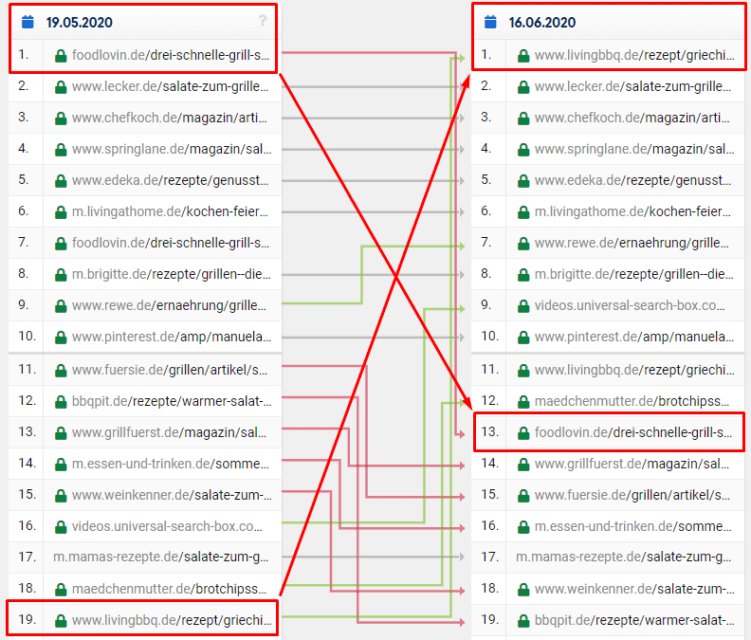

Nun siehst Du, welche URL für ein Keyword Rankingpositionen verloren beziehungsweise gewonnen hat. Beispielsweise ist Foodlovin’s Landingpage für „Salat zum Grillen“ von Position 1 auf 13 gefallen, während livingbbq von Position 19 auf die 1 hochgeschossen ist. Dies ist ein Ansatzpunkt, sowohl die eigene URL als auch die der Gewinner-Konkurrenten genau zu betrachten.

5. URLs analysieren.

Um Ranking-Änderungen auf URL-Ebene zu analysieren, solltest Du zunächst besonders betroffene URLs und Verzeichnisse identifizieren. Sieh Dir dazu die verschlechterten Keywords an. Nun beantworte für die betroffenen URLs einige Fragen:

- Wurden Änderungen mit Bezug zu den URLs durchgeführt? Dies bedeutet zwar nicht automatisch, dass Du die Änderungen zurückdrehen musst. Du solltest aber die korrekte Implementierung prüfen und, falls sich keine Verbesserungen einstellen, eine detaillierte Datenauswertung durchführen.

- Funktionieren die URLs Mobil und Desktop perfekt? Ich teste dies manuell und nutze zudem

- Welche Konkurrenz-Landingpages haben Rankings für die verlorenen Keywords gewonnen? Was machen diese besser?

- Das können offensichtliche Aspekte sein, wie eine andere Aufbereitung der Inhalte.

- Es können aber auch technische Aspekte dahinterstecken, die nicht auf den ersten Blick erkennbar sind. Beispiele sind eine schnellere Ladezeit der Konkurrenten, fehlerhafte schema.org Auszeichnungen der eigenen Seite oder gelöschte interne Links.

- Ebenso können speziell mobil Layout- und UX-Aspekte eine Rolle spielen, etwa, ob die relevanten Seiteninhalte bereits im ersten Seitenbereich sichtbar sind.

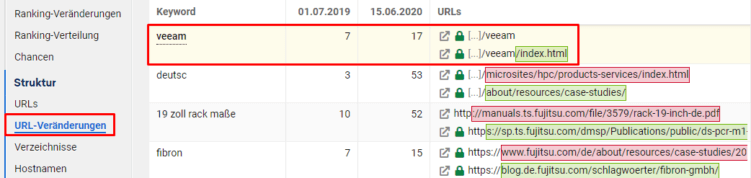

Zudem kannst Du noch prüfen, ob interne Kannibalisierungsgefahr besteht und deshalb Rankings leiden. Ein Hinweis darauf ist es, wenn Rankings für ein Keyword zwischen zwei verschiedenen URLs switchen. Betrachte dafür die „URL-Veränderungen“:

Nun hast Du gesehen, wie Du den Sistrix-Sichtbarkeitsindex richtig nutzt und Sichtbarkeitsverluste interpretierst. Mich beunruhigen weniger die stetigen Aufs und Abs in der Sichtbarkeit, sondern vor allem langsame Sichtbarkeitsverluste über eine längere Zeit. In diesem Fall solltest Du die ganze Website einem gründlichen SEO-Check unterziehen.

Der richtige Lösungsweg hängt vom Einzelfall ab: SEO-Probleme erforschen und beheben, das kann Dir Sistrix nicht abnehmen. In den Blogposts zu Rankingverlusten und Rankingabsturz verstehen findest Du aber gute Tipps, wie es geht. Wenn Du Unterstützung dabei möchtest, melde Dich, wir beraten Dich gerne!