Die 6 häufigsten Gründe für plötzlichen Rankingverlust (und die Lösungen dazu!)

Manchen mutet es wie ein Alptraum an: Man wacht auf und plötzlich sind die guten Rankings verschwunden und die eigene Seite wird bei Google nicht mehr gefunden. Doch keine Panik! Du kannst den Grund sehr oft herausfinden – oder zumindest mehrere Gründe eingrenzen. Heute will ich Dir die häufigsten Ursachen für Rankingverluste vorführen.

So kann sich ein Absturz der Rankings durchaus einmal anfühlen!

#1 Panda

Am 12.8.2011 wurde das erste Google Panda Update ausgerollt, seitdem gab es viele weitere Panda Updates. Der Namensgeber war nicht etwa ein Tier, sondern der zuständige Ingenieur bei Google namens Navneet Panda. Am 22. Juli 2015 fand das letzte offizielle Update namens Panda 4.2 statt. Im Januar 2016 gab Google bekannt, dass Panda nun ein Teil des sogenannten Core-Algorithmus sei. Damit werden künftig keine Updates mehr veröffentlicht. Das bedeutet aber nicht, dass das Prinzip des Algorithmus nicht mehr vorhanden ist – im Gegenteil! Panda ist heute einfach ein Teil des Algorithmus und wird dauerhaft berechnet, anstatt „nur“ in Abständen von einigen Monaten.

Diagnose

Google Panda ist ein reines Onpage Update und hat überhaupt nichts mit Links zu tun. Betroffen sind vor allem News-Seiten mit Low-Quality-Content, sowie Arbitrage-Modelle (Thin Affiliate Seiten und Preisvergleiche), aber auch Seiten mit wenig redaktionellem Content und vielen doppelten Inhalten oder Inhalten, die es auch auf anderen Webseiten gibt. Zur Diagnose beim ersten Panda Update eignete sich damals ein Vergleich Deiner Absprungrate und der Seiten pro Besuch im Vergleich zur Konkurrenz.

Heute ist es vor allem eine gesunde Portion Ehrlichkeit: Bietest Du dem User wirklich einen Mehrwert oder ist der alleinige Zweck Deiner Seite, dass Du Geld verdienst? Der tausendste Shoppingclub für Mode mag vielleicht in Deinen Augen ein revolutionäres Modell sein – für Google ist es das (normalerweise) aber nicht.

Behebung

Panda beziehungsweise dessen Nachfolger im Core-Algorithmus ist sehr schwer wieder zu beheben. Meistens benötigt man große Anstrengungen, insbesondere in Hinblick auf die Qualität des Contents der eigenen Webseite. Das betrifft oft das gesamte Geschäftsmodell im Kern: Seiten, die vorher aufgrund des geringen Aufwands rentabel waren, sind es durch eine Anwendung aller „Anti-Panda“ Maßnahmen meist nicht mehr. Der „Shoppingclub für Mode“ lohnt sich nicht mehr, wenn Du ihn mit Qualität aufforsten musst.

Wer trotzdem raus aus Panda will, sollte sich auf den User fokussieren: Wie kannst Du die Seite derart gestalten, dass User in Zukunft zufriedener mit der Webseite werden? Außerdem solltest Du duplicate Content so gut es geht bekämpfen – wichtiger bleibt aber der User-Fokus.

Dieses offizielle Google-Video zeigt einige der Website-Typen, die betroffen sein können, auch wenn es eher um Low-Quality-Content an sich geht.

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

#2 Penguin

Google Penguin wurde am 24.04.2012 erstmalig ausgerollt. Das letzte große Update (Penguin 4.0) war Anfang Oktober 2016 und ist damit gar nicht so lange her.

Diagnose

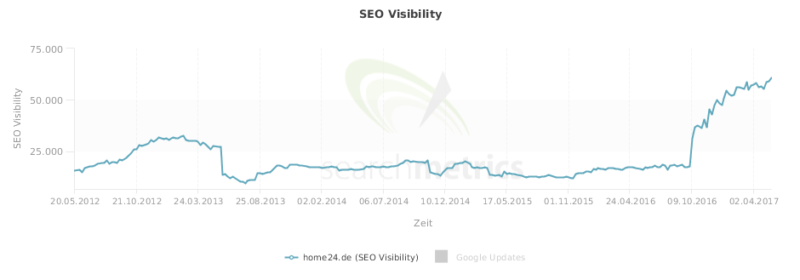

Penguin ist ein algorithmisches Update und bestrafte Webseiten, die übermäßigen Linkaufbau oder Linkaufbau mit qualitativ minderwertigen Links betrieben. Während Penguin 1.0 noch rein auf Anchortexte abzielte, war Penguin 2.0 schon granularer. Sehr viele Seiten lagen zwischen Juni 2013 und Oktober 2016 – also mehr als drei Jahre – in einem großen Penguin-Filter. Das bekannteste Beispiel ist Home24.de, ein großer Möbel-Online-Shop von Rocket Internet.

Betroffene Seiten wurden zum Stichtag massiv für wichtige Keywords nach unten geschoben. Wer also zu viele Links mit dem Anchortext „Couch“ aufbaute, der kam durch Penguin von Position 1 oder 2 plötzlich auf Position 90 oder noch weiter nach hinten. Da es insgesamt nur vier Updates in vier Jahren gab und aus meiner Sicht eigentlich nur Penguin 2 und 4 wirklich große Auswirkungen hatten, war es natürlich besonders bitter, wenn man erwischt wurde. Ein wenig über das „Drama“ von Home24.de und die Hintergründe könnt Ihr auf OnlineMarketing.de nachlesen.

Sichtbarkeit von Home24 über die Zeit. Man sieht gut den Knick Mitte 2013 und dann natürlich die Erholung aus dem Filter. (Quelle: Searchmetrics)

Wenn Deine Webseite also seit Oktober 2016 plötzlich wieder gut rankt, dann ist das vielleicht auf Linkbereinigungsmaßnahmen zurückzuführen, die bereits vor ein oder gar zwei Jahren gemacht wurden.

Behebung

Schlechte, gespamte und gekaufte Links sollten nach Möglichkeit entfernt oder disavowed werden. Geht dabei ruhig großzügig vor und entfernt im Zweifel mehr Links als gedacht. In der Regel helfen Dir dabei auch die gleichen Agenturen, bei denen Du vorher die Links gekauft hast – und bieten Euch hinterher bessere Links an, die sich dann mindestens bis 2019 „halten“. Aber im Ernst: Mein Rat ist es im Jahr 2017 diese schlechten Links zu entfernen und dann von Linkkauf und Linkspam die Finger zu lassen. Der schnellste Weg an viel Geld zu kommen ist es ja auch, wenn man eine Bank ausraubt. Trotzdem würde ich das nicht empfehlen!

Bevor mich jetzt wieder der Mob durch die Straßen jagt: Ja, sauberes Linkbuilding mit echten und tollen Kooperationen ohne Links zu kaufen ist natürlich weiterhin ok. Auch wenn ich das nie in der freien Wildbahn sehe… Wir bei Seokratie nutzen unsere Zeit lieber mit sinnvollen Maßnahmen.

#3 Warnung über unnatürliche Links

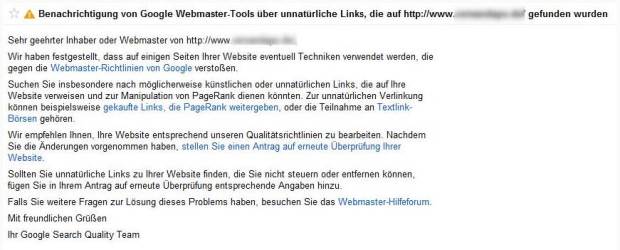

Die Warnung über unnatürliche Links kam das erste Mal am Wochende um den 20.07.2012 an deutsche Webmaster. Seitdem gehen die Meldungen bis heute regelmäßig bei vielen Seiten ein.

So sieht sie aus, die Meldung über unnatürliche Links (Bild von den Internetkapitänen)

Diagnose

Hier ist die Diagnose einfach: Man erhält eine Nachricht über „unnatürliche eingehende Links“ in den Google Webmastertools. Ein Google-Mitarbeiter hat sich also manuell die Links zur Webseite angesehen und vermutet, dass die Webseite Links gekauft hat, um ihr Ranking zu verbessern. In der Regel dauert es dann nur wenige Tage bis erste Rankingverluste spürbar sind. Das betrifft in den meisten Fällen bestimmte Verzeichnisse oder Dokumente, seltener sogar die komplette Webseite. Die Auswirkungen dieser Nachricht können kaum spürbar sein oder sehr massiv, je nach Grad der Penalty.

Behebung

Diese Maßnahme von Google ist manuell und kann daher auch nur manuell wieder gelöst werden. Als erstes sollte man sich eine große Linkliste anlegen, jeden einzelnen Link durchgehen und auf Natürlichkeit prüfen. Teilweise geht das auch halbautomatisiert: Ein super Tool dafür, das wir auch seit Jahren nutzen, ist DTOX von den Linkresearchtools.

Google-Mitarbeiter wissen oft sehr genau, welche Links gekauft sind und welche nicht. Ich erkenne nach zehn Jahren SEO einen gekauften Link hundert Meter gegen den Wind, bei Search-Quality-Mitarbeitern ist das etwas, was man als erstes lernt – mit einem Sammelsurium an internen Google Tools und Daten. Es reicht nicht, wenn Du nur ein paar Links löschst, sondern Du solltest wirklich großflächig arbeiten. Die entsprechenden Webmaster solltest Du nett anschreiben und sie bitten, die Links zu entfernen. Reagieren die Webmaster nicht, dann kannst Du die Links mittels des Disavow Tools (in den Google Webmastertools) entfernen.

Herauskommen sollte eine Liste mit Domains, die Du dann öffentlich zugänglich in Google Docs anlegst. Diese Liste referenzierst Du anschließend im sogenannten „Antrag auf erneute Überprüfung“, den Du auch in den Google Webmastertools stellst. Ein Google-Mitarbeiter sieht sich dann an, ob entsprechende Maßnahmen unternommen wurden, damit die Webseite wieder den Richtlinien für Webmaster entspricht. In den Antrag solltest Du auf jeden Fall auch schreiben, was Du früher „verbrochen“ hast, dass es Dir leid tut und Du es niemals wieder tun wirst. Geht der Antrag durch, bekommst Du die Nachricht „Manuelle Spam Maßnahmen aufgehoben“ und solltest bald wieder bessere Rankings haben. Falls er nicht genehmigt wurde ist es auch nicht schlimm: Meistens erhälst Du dann eine Liste mit drei konkreten Beispiellinks, die noch gegen die Richtlinien verstoßen. Wichtig ist, dass Du nicht nur diese drei Links entfernst, sondern deutlich mehr!

Gefällt Dir dieser Blogpost? Wenn Du regelmäßig die neuesten Trends im Online Marketing mitbekommen willst, dann abonniere jetzt unseren Newsletter. Über 18.000 Abonnenten vertrauen uns.

Jetzt abonnierenHier die offizielle Hilfeseite von Google zur Warnung über unnatürliche Links.

#4 Schlechte User-Experience

Diagnose

Du optimierst auf ein bestimmtes Keyword und die Rankings steigen gut bis Seite 1, danach fällt die Seite aber oft auf Position 10 oder Seite zwei zurück. Dann hat diese Seite eine schlechte User Experience und passt nicht zur Suchanfrage.

Behebung

Überlege Dir, was an Deiner Seite nicht zur Suchanfrage passen könnte und versuche möglichst viele Suchintentionen abzudecken. Mehr Infos darüber gibt es im Blogpost SEO für Landingpages.

#5 Veraltete Webseite

Diagnose

Deine Domain verliert langsam, aber stetig an Rankings. Es gibt keine großen Abstürze, sondern ein eher langsames Abgleiten in die Bedeutungslosigkeit.

Behebung

Hier wird es knifflig. Die Beispiele, die ich bisher gesehen habe, hatten unterschiedlichste Gründe für den „Slow Death“. In der Regel spielt Userverhalten eine sehr große Rolle. Die Seite wird immer weniger angeklickt, das Design ist eventuell nicht mehr zeitgemäß und / oder der Content nicht (mehr) gut genug. Auch nachlassende Brand-Suchanfragen (Suchen nach „Domain.de“) können ein schlechtes Signal sein. Und natürlich kann es auch daran liegen, dass immer mehr alte Links entwertet werden oder wegfallen.

Vielleicht hilft Dir auch dieser Artikel: 12 Gründe, warum Dein Online Shop nicht richtig rankt.

Viele verschiedene User bestimmen mittlerweile das Ranking Deiner Webseite – denn Nutzersignale spielen eine sehr große Rolle.

#6 Technische Probleme

Diagnose

Deine Domain verliert scheinbar willkürlich Rankings. Ein bestimmtes Verzeichnis oder nur bestimmte Keywords verlieren.

Behebung

Puh, da wartest Du am besten auf unseren nächsten Blogpost, den Felix bald veröffentlicht. Die Gründe können vielschichtig sein. Heutzutage kann Google bei Onpage-Fehlern, besonders was Struktur und Auszeichnungen angeht, sehr empfindlich sein.

Potenzielle Kandidaten sind oft:

- Ladezeit der Webseite oder von Seitenbereichen

- Probleme mit dem Rendern einer Webseite oder Content(teile) sind nicht crawlbar

- Hreflang-„Verwechslungen“

- Canonicals nicht (mehr) richtig gesetzt

- Serverseitige Probleme im Allgemeinen

- und viele mehr! 🙂

Gemeinsamkeit bei Rankingverlusten: Ändere Deine Arbeitsweise

Viele Rankingverluste haben gemeinsam, dass der Webmaster sich ernsthaft Gedanken über die Art und Weise, wie er im Internet Geld verdient, Gedanken machen sollte. Billiger Linkaufbau und schlechter Content gingen noch 2010, aber diese Zeit ist schon lange abgelaufen. Gerade in großen Teams sollte man sich zusammensetzen und prinzipiell darüber diskutieren, wie man SEO überhaupt definiert. Mit Onpage und Linkbuilding alleine kommst Du heute nicht mehr langfristig voran. Du brauchst eine gute Webseite, gute Inhalte und gute Produkte, die von echten Menschen gemocht werden und die nicht nur für Suchmaschinen erstellt wurden.

Wenn Du Rankingverluste hinnehmen musstest aber nicht weißt warum: Wir helfen Dir gerne weiter!

Bilder Asteroideneinschlag © iStock/Celafon – Menschen vor Laptops © iStock/ yuoak