Duplicate Content: Gefahren verstehen, finden & vermeiden

Vage haben die meisten Webseitenbetreiber davon gehört: Duplicate Content ist gefährlich! Google mag das nicht! Stimmt auch. Aber das ist kein Grund zur Panik. Zumindest nicht mehr. Denn hier erfährst Du, was sich dahinter verbirgt und worauf Du achten musst.

Meine Duplikate können ganz schön nervig sein.

Was ist Duplicate Content?

Duplicate Content (also „doppelte Inhalte“, kurz „DC“) sind Inhalte, die identisch auf mehreren Seiten im Internet vorkommen. Es handelt sich dabei nicht nur um kopierte Texte, sondern vor allem um komplett identische Einzelseiten. Es wird unterschieden in internen und externen Duplicate Content: Intern bedeutet, die gleichen Inhalte sind auf einer Domain – also beispielsweise auf Seokratie.de. Extern bedeutet, dass die Inhalte auf mehreren Domains vorkommen.

Duplicate Content verursacht Suchmaschinen wie Google Probleme. Deshalb werden dort die Inhalte der betroffenen Seite schlechter gefunden oder gar herausgefiltert. Damit eine Webseite keine Ranking-Probleme wegen Duplicate Content hat, muss jede indexierte Seite genügend „Unique Content“ haben. „Unique Content“ sind Inhalte, die nur für eine Seite erstellt wurden und nur auf dieser vorkommen.

Warum ist Duplicate Content ein Problem?

Der Googlebot mag keinen Duplicate Content. Und wenn er zu viel auf einer Domain findet, dann wird er sauer. Die Folge sind Abstrafungen und Zurücksetzungen im Ranking.

Für Google ist Duplicate Content ein großes Thema. Zum einen ist es schwer, algorithmisch herauszufinden, welche Seite einer Domain am passendsten für eine Suchanfrage ist. Außerdem will Google Crawling-Ressourcen sparen und nicht 100 Versionen einer gleichen Seite crawlen, weil das in den Maßstäben von Google wirklich immens viel Geld ist, das an Hardwareleistung verschwendet wird. Die Grundlagen zum Thema gibt es direkt von Google: „Duplizierter Content“.

Ab wann ist Duplicate Content ein Problem?

Ein richtiges Problem mit Duplicate Content hast Du vor allem dann, wenn Google sich nicht entscheiden kann, welche Seite relevanter ist, und sich daher mehrere Seiten im Ranking abwechseln. Aber nachdem Du vermutlich eine Zahl hören möchtest: Sobald Du mehr doppelte als einzigartige Inhalte hast, hast Du ein Problem. Spätestens. Die perfekt suchmaschinenoptimierte Seite besteht aus 100% Unique Content – in der Theorie.

Was sind typische Beispiele für Duplicate Content?

Duplicate Content hat viele Gesichter. Ein paar der Klassiker sind diese:

- Websites, die via https://example.com, http://example.com, http://www.example.com und https://www.example.com erreichbar sind (und nicht weiterleiten)

- Über Groß- und Kleinschreibung erreichbare URLs wie example.com/Beispiel und example.com/beispiel

- Eigene URLs für Druckversionen

- Zusätzliche PDFs mit Produktinfos wie technischen Details, die auch auf der Produkt-Landingpage angegeben werden (sollten)

- Vielzählige Produktdetailseiten zu bestimmten Größen, Farben und Formen

- Parameter für Affiliate-URLs wie ?partnerid=2858

- Parameter-URLs für Sortierung und Darstellung von Produktübersichten

- /index.htm, /de/ und ähnliche Dinge, die Content-Management-Systeme produzieren

- Automatisch generierte Tag-Seiten

- Und in gewisser Form auch Paginierungsseiten

Die Liste lässt sich vermutlich ewig weiterführen. Und irgendwas davon gibt es auf jeder Domain – garantiert.

Wie kannst Du Duplicate Content finden?

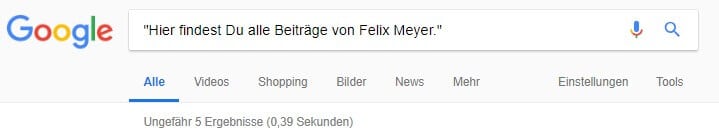

Der einfachste Weg, wie Du DC auf Deiner Seite finden kannst, ist Textbausteine zu googlen. Setze den Textbaustein einfach in Anführungszeichen und los geht es:

Um die doppelten Inhalte auch wirklich zu finden, musst Du dann noch auf diesen Link klicken, um auch die herausgefilterten doppelten Seiten anzuzeigen:

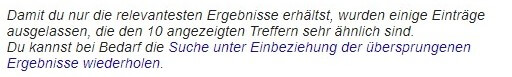

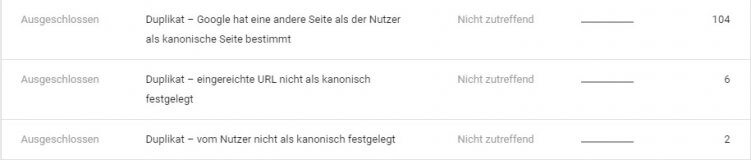

Nachdem es aber etwas umständlich wäre, sämtliche Textbausteine zu suchen, gibt es auch hilfreiche Tools. In Googles neuer Search Console gibt es den Report „Indexabdeckung“. Dazu musst Du im Diagramm auf die „Ausgeschlossenen“ klicken:

Dann siehst Du unten auch einige Typen, bei denen Google selbst Dir sagt, dass sie eine Seite als Duplikat einer anderen URL eingestuft haben:

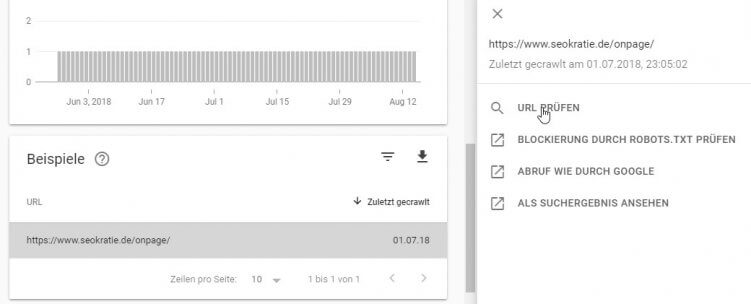

Mit einem Klick auf die betroffene URL klappt sich ein Menü auf, bei dem Du direkt in das URL-Prüfungs-Tool springen kannst. Dort siehst Du dann sogar, welche die doppelte URL ist.

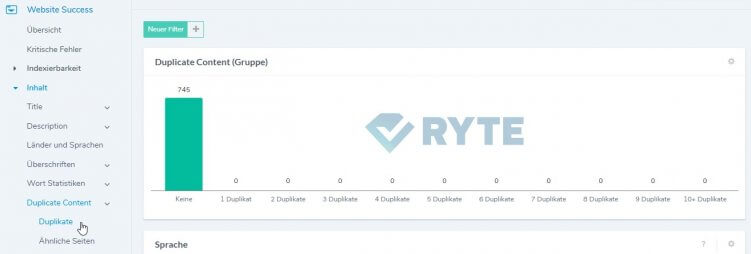

Aber auch über andere Onpage-Tools wie beispielsweise Ryte kannst Du doppelte Inhalte finden. Sinnvollerweise zu finden unter „Inhalt“ > „Duplicate Content“:

Selbstverständlich sehen bei uns nicht alle Seiten so sauber und grün aus.

Ryte unterscheidet in Duplikate – also komplett doppelte Seiten – und ähnliche Seiten beziehungsweise „Near Duplicate Content“. Letztere sind oft aber sogar gefährlicher, weil sie meist ungewollt sind und von Google nicht einfach als Duplikate aussortiert werden. Beides sind also sehr praktische Reports, um Duplicate Content zu finden.

Wie kannst Du Duplicate Content vermeiden?

Es gibt verschiedene Lösungen, um Duplicate Content zu vermeiden. Die Grundlegendste: DC gar nicht erst entstehen lassen. Es fängt bei einer sauberen Crawlingsteuerung an. Heißt, dass Du doppelte Inhalte nicht verlinken solltest, damit Suchmaschinen sich nicht damit rumschlagen müssen.

Wenn die doppelte Seite aber schon da ist, dann solltest Du sie im Idealfall direkt per 301-Weiterleitung auf die gewollte Original-URL weiterleiten. Dann bleibt Deine Seite schön schlank und gesund.

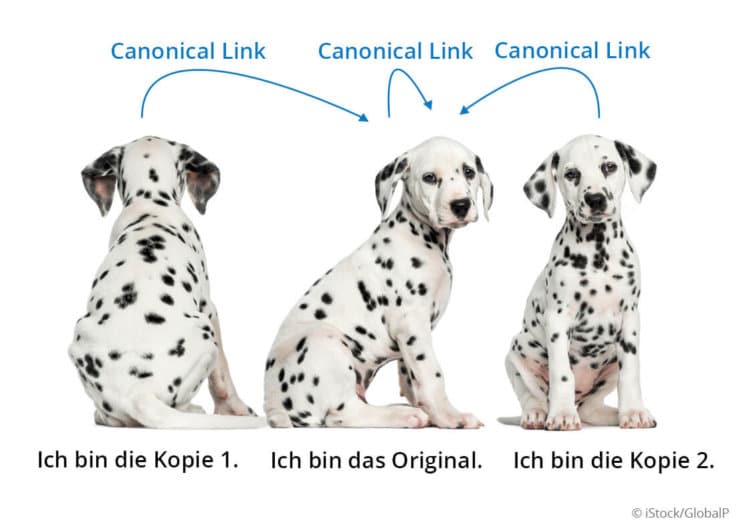

Nun gibt es aber auch doppelte Inhalte, die für Deine Besucher einen Nutzen haben. Beispielsweise URLs mit Sortierungen, Affiliate-URLs oder Produktvarianten. Diese Seiten darfst Du behalten, aber sie müssen per Canonical-Link auf die Original-URL verweisen. So sieht das dann aus:

<link rel=“canonical“ href=“https://www.seokratie.de/duplicate-content-bei-google-vermeiden/“ />

Dieser für Nutzer nicht sichtbare Link im <head> Deiner Seite sagt Suchmaschinen, welche Seite in den Suchergebnissen erscheinen soll. Suchmaschinen verstehen dann die doppelte URL und die Original-URL als einen Inhalt und können damit umgehen.

Wenn Du wissen möchtest, wie Canonicals genau funktionieren, dann lies Luisas ausführlichen Artikel über Canonicals.

Wenn Du doppelte Inhalte hast, die in keiner Version im Index erscheinen sollen – etwa sehr ähnliche Verteilerseiten, die nur zur Navigation dienen – dann solltest Du diese per Robots-Metatag auf „noindex,follow“ stellen, um sie aus Suchmaschinen auszuschließen. Noch besser ist es allerdings, wenn Du die gesamte Existenz dieser Seiten hinterfragst.

Wenn Du doppelte Inhalte hast, die beide über die Suche auffindbar sein sollten, dann hilft nur eins: Du musst diese Inhalte individualisieren. Auch wenn all Deine Services identisch sind, egal ob Du beispielsweise einen Laptop oder Desktop-PC reparierst: Wenn Du willst, dass die Leistungen separat auffindbar sind, musst Du für sie jeweils eigene Inhalten formulieren. Das gilt selbstverständlich auch für Produktbeschreibungen in Online Shops.

Tipp: Duplicate Content durch Druckversionen vermeiden

Statt eigene URLs für Druckversionen zu verwenden, kannst Du übrigens in Deinem CSS für Deine „normalen“ URLs über den Medientyp „print“ eine angepasste Darstellung für den Druck hinterlegen. Das sieht dann in etwa so aus:

@media print {

body {

color: #000;

background-color: #fff;

}

}

Spezialfälle von Duplicate Content

Wiederkehrende Textbausteine

Auch nur einzelne Absätze, die auf mehreren Deiner Seiten vorkommen, sind eine Form von Duplicate Content. Google selbst nennt das „wiederkehrende Textbausteine“:

„Minimieren Sie wiederkehrende Textbausteine: Anstatt am Ende jeder Seite umfangreiche Urheberrechtshinweise einzufügen, können Sie lediglich eine kurze Zusammenfassung mit einem Link zu detaillierten Informationen aufführen.“

Das ist eine nicht unerhebliche Information. Versuche so wenig Text wie möglich in Footer & Co. zu packen. Auch Versandinformationen und andere Dinge sind Duplicate Content! Google reagiert da recht empfindlich, besonders wenn Du 300 Wörter an umfangreichen Infos über Deinen tollen Shop ans Ende jeder einzelnen Webseite packst. Was daran (für den User) schlecht sein soll, weiß ich nicht. Google wird es schon wissen.

Externer Duplicate Content

Wenn Inhalte auf mehreren Domains vorkommen, muss sich Google für ein Original entscheiden. Im Regelfall ist das die Seite, auf der der Googlebot zuerst den Inhalt gefunden hat. Aber auch andere Signale wie beispielsweise Links zur Quelle sind für Google ein Indiz.

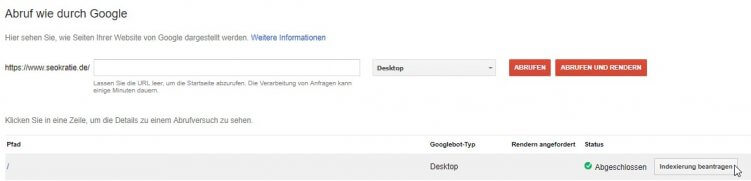

Wenn Du also eine Pressemitteilung veröffentlichst und für diese Deine Seite gefunden werden soll, solltest Du sicher gehen, dass Du zuerst veröffentlichst. Entscheidend ist, dass Google Deine Seite zuerst crawlt. Das kannst Du beschleunigen, indem Du in der Google Search Console via „Crawling“ > „Abruf wie durch Google“ bei der abgerufenen URL auf „Indexierung beantragen“ klickst.

Für das Original ist externer Duplicate Content nicht besonders problematisch. Verwendest Du aber Inhalte von Lieferanten für Produktbeschreibungen, werden diese wahrscheinlich auch von anderen Websites verwendet. Dann ist es sehr unwahrscheinlich, dass Deine Seite gefunden wird. Du solltest Deine Produktbeschreibungen daher immer selbst erstellen.

Wenn Du aber Zitate verwendest, ist das in der Regel kein Problem. Um ganz sicher zu gehen, kannst Du diese im Quellcode über das Tag „blockquote“ als Zitate auszeichnen:

Du willst keine unserer Beiträge mehr verpassen und auf dem Laufenden bleiben? Abonniere jetzt unseren Newsletter und erhalte jeden neuen Seokratie-Beitrag per E-Mail direkt in Dein Postfach!

Hier geht es zum Anmeldeformular.<blockquote>Dies ist ein Zitat.</blockquote>

Internationaler Duplicate Content

Wenn Du in Deutschland, Österreich und der Schweiz aktiv bist, hast Du wahrscheinlich jeweils eigene Seiten mit entsprechend angepassten Preisen, Telefonnummern und Versandinformationen. Damit Du in diesem Fall keine Probleme mit Duplicate Content bekommst, wurde die „hreflang“-Auszeichnung erfunden. Damit sagst Du im <head> Deiner Seite den Suchmaschinen, welche der Seiten für welches Land und für welche Sprache gedacht ist. Dieser Code sagt beispielsweise, dass Example.de auf Deutsch und für Deutschland ist, Example.at ist auf Deutsch und für Österreich:

<link rel="alternate" hreflang="de-de" href="https://www.example.de/duplicate-content"/> <link rel="alternate" hreflang="de-at" href="https://www.example.ate/duplicate-content"/>

Für die entsprechenden Details liest Du am besten Luisas ausführlichen Artikel zum Thema hreflang.

Wenn trotz hreflang Chaos ist

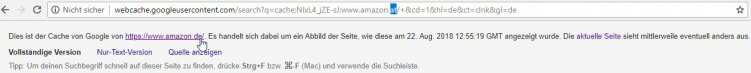

Auch mit definierten hreflangs kann es Dir passieren, dass Google zu ähnliche internationale Seiten zusammenfasst – das siehst Du beispielsweise daran, dass in Googles Cache für amazon.at die Seite amazon.de hinterlegt ist:

Auch wenn der Cache nichts mit der Indexierung zu tun hat, ist das ein Indiz dafür, dass die Seiten von Google im Index „zusammengeklappt“ werden. Vermutlich hat das mit Effizienz zu tun. Vor einem Jahr noch führte das zu unschönen Vermischungen zwischen den Ländern und auch zu Rankingproblemen, mit denen viele zu kämpfen hatten. Seit Oktober 2017 spielt Google aber einfach die entsprechende URL für das passende Land aus. Aus unserer Sicht ist es daher (im Regelfall) nicht notwendig, die Inhalte für die verschiedenen Länder zu individualisieren. Für Deine Besucher kann das aber sehr sinnvoll sein.

Wie schlimm ist Duplicate Content wirklich?

Das Schlimme an Duplicate Content ist, dass sich die Auswirkungen meistens gar nicht zeigen. Trotzdem handelt es sich um Ballast auf der Seite, der einen bremst.

Erst wenn Deine Seite Tausende URLs hat und Dein Seitenaufbau dadurch immer komplizierter wird (Canonicals, Hreflang, verschiedene Domains), werden die Probleme so richtig gravierend. Als Hobby-Seitenbetreiber hast Du in der Regel keine großen Probleme mit DC – sofern Du Deine Inhalte selbst schreibst und Du die wildesten Auswüchse Deines Content-Management-Systems im Blick hast.

Wenn Du das Thema SEO noch besser verstehen möchtest, empfehle ich Dir Julians Buch Suchmaschinenoptimierung für Dummies und unseren Newsletter. Und wenn Du mal professionelle Hilfe brauchst, kannst Du Dich natürlich gerne bei uns melden.