6 typische SEO-Fehler, die Du unbedingt vermeiden solltest

Du hast eine Website und die Rankings bleiben aus? In meinen 14 Jahren als Suchmaschinenoptimierer habe ich schon einige Gründe dafür gesehen. Heute präsentiere ich Dir daher die häufigsten Fehler, die Anfänger beim Thema SEO zu Beginn machen.

Jeder fängt einmal klein an! Doch viele Fehler können Anfänger von Beginn an vermeiden!

Inhalt

Den kompletten Blogpost gibt es auch als Video:

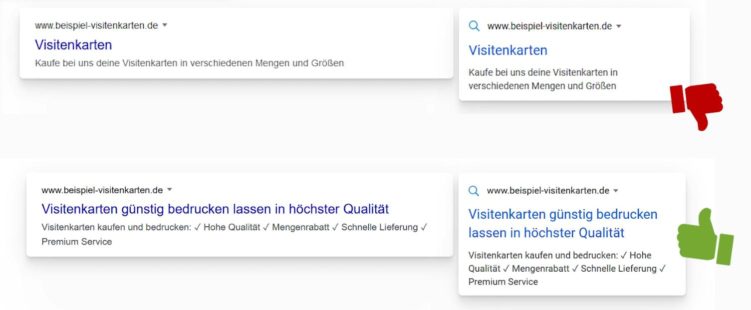

1. Titles und Descriptions

Das Snippet ist einer der wichtigsten Faktoren für ein gutes Ranking. Ein Snippet ist die Vorschau Deiner Website oder Landingpage in den Suchergebnissen. Hier wird leider noch viel zu lieblos damit umgegangen, besonders von Anfängern. Oft heißt es, man soll das Keyword in den Title schreiben. Das stimmt natürlich – aber man muss normalerweise viel mehr tun! Nicht nur das Keyword gehört in den Title, sondern auch das, was Dich und Dein Unternehmen besonders macht.

- Wieso sollte man bei Deinem Shop bestellen?

- Was macht Dein Unternehmen besonders?

- Was sind die Alleinstellungsmerkmale? Überlege Dir, was der User möchte, wenn er nach diesem Keyword googelt.

Nehmen wir das Beispiel Visitenkarten: Hier möchte der User hochwertige Visitenkarten, oft will er sie auch schnell versendet haben und sie sollen natürlich auch günstig sein. In den Title kannst Du jetzt schreiben „Visitenkarten“ oder Du schreibst hinein: „Visitenkarten günstig bedrucken lassen in höchster Qualität“.

Gute Titles und Descriptions erhöhen die CTR

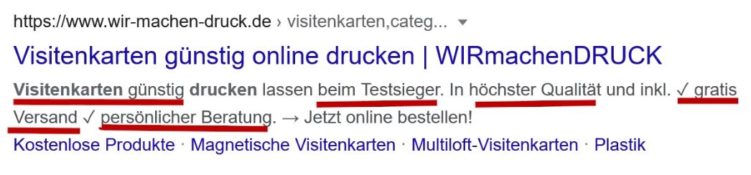

Gut ist hier das Ergebnis von WirMachenDruck, die auf kleinstem Raum schreiben:

- Visitenkarten günstig

- beim Testsieger

- in höchster Qualität

- gratis Versand

- persönliche Beratung.

So sieht es gut aus! Wir machen Druck macht es richtig.

Teste Deine Titles und Descriptions und sieh Dir in der Google Search Console an, ob die Klickrate sich verbessert oder verschlechtert. Dann kannst Du in der Regel eine Menge guter Ergebnisse einfahren.

2. Duplicate Content

Der zweite Basic-Fehler, den viele Einsteiger im SEO-Bereich machen, ist, dass man sich nicht bewusst ist, dass man für ein Keyword eine URL aussuchen sollte – und hier Ordnung halten muss. Duplicate Content entsteht, wenn Ihr mehrere URLs habt, die identische oder sehr ähnliche Inhalte haben. Es gibt aber auch oft Probleme, weil ihr mehrere Landingpages habt, die letztlich irgendwie das gleiche Thema haben. Wenn Ihr eine URL habt mit „Visitenkarten“ und die nächste mit „Visitenkarten für Firmen“, dann kann es sein, dass Google nicht weiß, welche der URLs sie für Visitenkarten und welche für „Visitenkarten für Firmen“ ranken soll.

Manchmal probiert der Algorithmus auch neue Dinge aus und testet, ob nicht vielleicht doch die andere URL besser passt. Das nennt sich dann Keyword-Kannibalisierung. Zwei URLs wollen für das gleiche Keyword ranken und ständig wechseln dann die URLs für das Keyword. Letztlich fressen sie sich dann gegenseitig auf. Manchmal ist es auch so, dass eine URL auf Platz 8 beispielsweise rankt und die andere auf Platz 15. Wenn man nun die URLs sauber zusammenführt, dann hat man plötzlich ein Ranking auf Platz 3 – was viel viel besser ist als die zwei schlechteren Rankings zusammen.

Dazu einmal ein kleiner Witz: Wo ist der beste Ort um eine Leiche zu verstecken? Auf Seite 2 von Google! Haha.

Also: Achte darauf, dass Du immer eine URL für ein Keyword hast – vermeide Duplicate Content und vermeide auch Keyword-Kannibalisierung.

3. Fehlende Landingpages

Ein weiterer SEO-Basic-Fehler den viele machen ist, wenn Du schlichtweg zu wenige Landingpages hast. Oft gibt es ein Hauptkeyword, das besonders lukrativ ist und ein hohes Suchvolumen hat, also viele Leute danach suchen. Aber daneben gibt es auch viele Keywords, nach denen vielleicht nicht so viele Leute googeln, die aber auch weniger Konkurrenz haben und daher sehr interessant sein können. Im Falle unseres Visitenkarten-Beispiels: Visitenkarten ist natürlich ein super Keyword. Aber wie wäre es mit einer Landingpage zum Thema Visitenkarten für Ärzte? Oder auch Visitenkarten für Friseure? Du siehst, dass fast jeder Beruf quasi ein neues, zusätzliches Keyword ist.

Der Clou dabei ist, dass solche Longtail-Keywords auch oft eine höhere Conversionrate haben. Das bedeutet, dass prozentual mehr Leute in Deinem Shop kaufen. Ist ja auch logisch, wenn ich genau das biete, wonach jemand sucht – also Visitenkarten für Ärzte, dann kaufe ich auch entsprechend mit mehr Wahrscheinlichkeit.

Im Longtail ist oft sehr viel zu holen!

Nun musst Du natürlich auf der Landingpage auch etwas Besonderes anbieten und sie natürlich speziell für Ärzte attraktiv machen. Hier liegt die Schwierigkeit: Je spezifischer, desto besser – aber wo hörst Du auf und ab wann lohnt es sich nicht mehr? Du könntest auch eine Landingpage machen mit „Visitenkarten für HNO Ärzte in München Süd.“, die natürlich dann noch besser funktioniert – aber vermutlich hast Du dann nur 4 oder 5 potenzielle Kunden und der Aufwand eine Landingpage zu erstellen lohnt sich nicht.

Hier fällt es oft schwer die Balance zu finden – aber in der Regel werden tendenziell eher zu wenige Landingpages generiert als zu viele.

Du willst keine unserer Beiträge mehr verpassen und auf dem Laufenden bleiben? Abonniere jetzt unseren Newsletter und erhalte jeden neuen Seokratie-Beitrag per E-Mail direkt in Dein Postfach!

Jetzt abonnieren4. Kein Mehrwert für den Nutzer

Ein weiterer häufiger Fehler ist es, wenn die eigene Website keinen Mehrwert für den Nutzer bietet. Zum Glück sehe ich solche Websites mittlerweile immer seltener. Wenn Du heute eine neue Website für „Visitenkarten bedrucken“ erstellen willst, dann musst Du einen Mehrwert bieten. Das bedeutet, dass Du in irgendeiner Weise besser sein musst als die Konkurrenz!

Was viele Gründer vergessen: Niemand hat auf Dich gewartet! Wenn Deine Website nicht professionell aussieht, der Bestellprozess nicht einfach und angenehm von statten geht und Deine Produkte oder Dienstleistungen nicht ansprechend sind, dann wirst Du untergehen.

Wenn Deine Texte nicht gut sind, dann werden Sie auch nicht ranken! Niemand sagt sich: „Och die sind ja neu und gerade erst gegründet, da kaufe ich der fairnesshalber mal ein, auch wenn alles nicht so optimal ist.“. Das habe ich vor über 14 Jahren mit meinen ersten kleinen T-Shirt-Shops auch schmerzlich erfahren müssen. Grundsätzlich gilt: Entweder mach es gleich professionell und richtig oder lass es einfach sein. Das klingt hart, aber so ist es.

Besonders in hart umkämpften Bereichen wie beispielsweise „Visitenkarten bedrucken“ musst Du schon mit einer besonders guten Website, viel Marketingbudget oder einer besonders neuen Idee kommen. Hier hilft dann oft wirklich eine Verfeinerung. Ich glaube, wenn Du nur Visitenkarten für Ärzte bedruckst – und zwar die gesamte Website nur darauf ausgerichtet ist – dann hast Du auch heute noch gute Chancen.

5. Seitenladezeit

Ein weiterer Punkt, den viele Einsteiger nicht richtig angehen ist die Seitenladegeschwindigkeit. Hier gibt es zwei Extreme: Entweder ist die Seitenladegeschwindigkeit zu langsam, weil die Website technisch einfach nicht gut gebaut wurde und darauf nicht geachtet wurde. In dem Fall solltest Du dringend darauf achten, dass Deine Website schneller lädt. Google und auch die User wollen heutzutage unbedingt schnell ladende Websites haben. Bist Du zu langsam, hast Du nicht nur nachweislich weniger Verkäufe auf Deiner Website, sondern auch schlechtere Rankings bei Google – denn langsame Websites bekommen von Google schlechtere Rankings verpasst.

Das andere Extrem sind Einsteiger, die bereits wissen, dass die Seitenladezeit ein wichtiger Faktor für ein gutes Ranking ist – und die dann alles daran setzen die schnellste Website zu sein. Da wird wirklich dann noch das Allerletzte aus der Website herausgeholt, so dass sie endlich einen Pagespeed-Score von 100 statt 99 bei Google Pagespeed (das ist ein kostenloses Tool von Google, das ein paar Werte zur Website-Geschwindigkeit checkt) holt. Hier haben wir ein super Video von Nora zum Thema, das wir Dir auch verlinken.

Wenn Du zur Kategorie der „Performer“ gehörst, dann musst Du leider folgendes erfahren: NUR mit einer schnellen Website kommst Du nicht nach vorne – es gehört einiges mehr noch dazu! Eine schnelle Website ist super und je schneller desto besser – jedoch gibt es irgendwann einen Punkt, an dem Kosten / Nutzen keinen großen Sinn mehr machen. Grundsätzlich solltest Du darauf achten, dass Du nicht viel langsamer als Deine Konkurrenz bist und im Vergleich mit zu den Schnellsten gehörst. Wenn Du das geschafft hast, stecke Deine Arbeit lieber in die Qualität des Contents, das Marketing oder andere Maßnahmen.

6. Zeit verbummeln

Der letzte häufige Fehler, den viele SEO-Einsteiger machen ist eigentlich eher eine Fehlersammlung: Und zwar ist das, wenn Du Deine Zeit in die falschen SEO-Maßnahmen steckst. Es gibt unzählige Hebel, die Du bei SEO bedienen kannst und viele verbessern Deine Website. Welcher dieser Hebel ist allerdings für Deine Website zu diesem Moment am wichtigsten?

Die wichtigen von den unwichtigen SEO Maßnahmen zu unterscheiden, das ist der Unterschied, der einen SEO Profi von einem Neuling unterscheidet. Ich weiß noch, dass ich an einem meiner ersten Tage als SEO meine Website in unzählige Webkataloge eingetragen habe und wirklich viel Zeit damit verschwendet habe. Viele Einsteiger verlieren beispielsweise recht viel Zeit in die Erstellung einer XML-Sitemap – dabei ist sie besonders für kleine Websites eigentlich gar nicht notwendig und hat keinerlei Auswirkungen auf das Ranking. Es ist ja auch so, dass Du, wenn Du zwei identische Schränke aufbaust, Du beim ersten Schrank normalerweise deutlich länger benötigst als beim Zweiten. So ähnlich verhält es sich mit SEO. Hier kann ich Dir nur den Tipp geben, dass Du strukturiert an SEO herangehen solltest. Das kannst Du mit meinem Buch Suchmaschinenoptimierung für Dummies machen oder mit dem von Sebastian Erlhofer. Verschaffe Dir einen Überblick was alles möglich ist und fange dann an, die für Dich wichtigsten Stellschrauben zu drehen.

Trotzdem wird jemand, der bereits mehrere Jahre SEO ist, Deine Stellschrauben schneller finden und vor allem die Richtigen drehen. Aber so ist das nun einmal. Jeder hat einmal angefangen und wenn Du wirklich SEO lernen willst, dann bleibt Dir eine gewisse Lernkurve nicht erspart. So, ich hoffe, ich konnte Dir mit meinen Tipps helfen und hoffentlich vermeidest Du ein paar dieser Einsteigerfehler gleich von Beginn an.

Titelbild: Tatyana Tomsickova Photography / Gettyimages